En el ámbito de la movilidad para personas ciegas, la innovación suele llegar envuelta en grandes promesas y discursos entusiastas. Sin embargo, pocas veces se pone el foco en lo que realmente importa: cómo se comporta una tecnología cuando abandona el laboratorio, la feria o el vídeo promocional y se enfrenta al mundo real, al asfalto, a las prisas del día a día, a los recorridos habituales y a las decisiones improvisadas que forman parte de cualquier desplazamiento cotidiano.

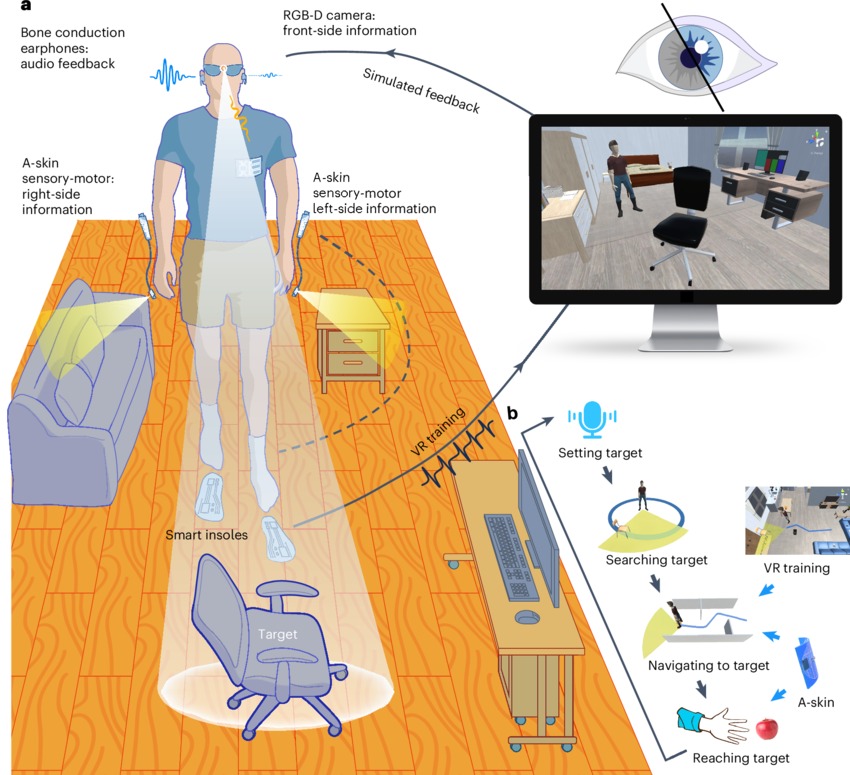

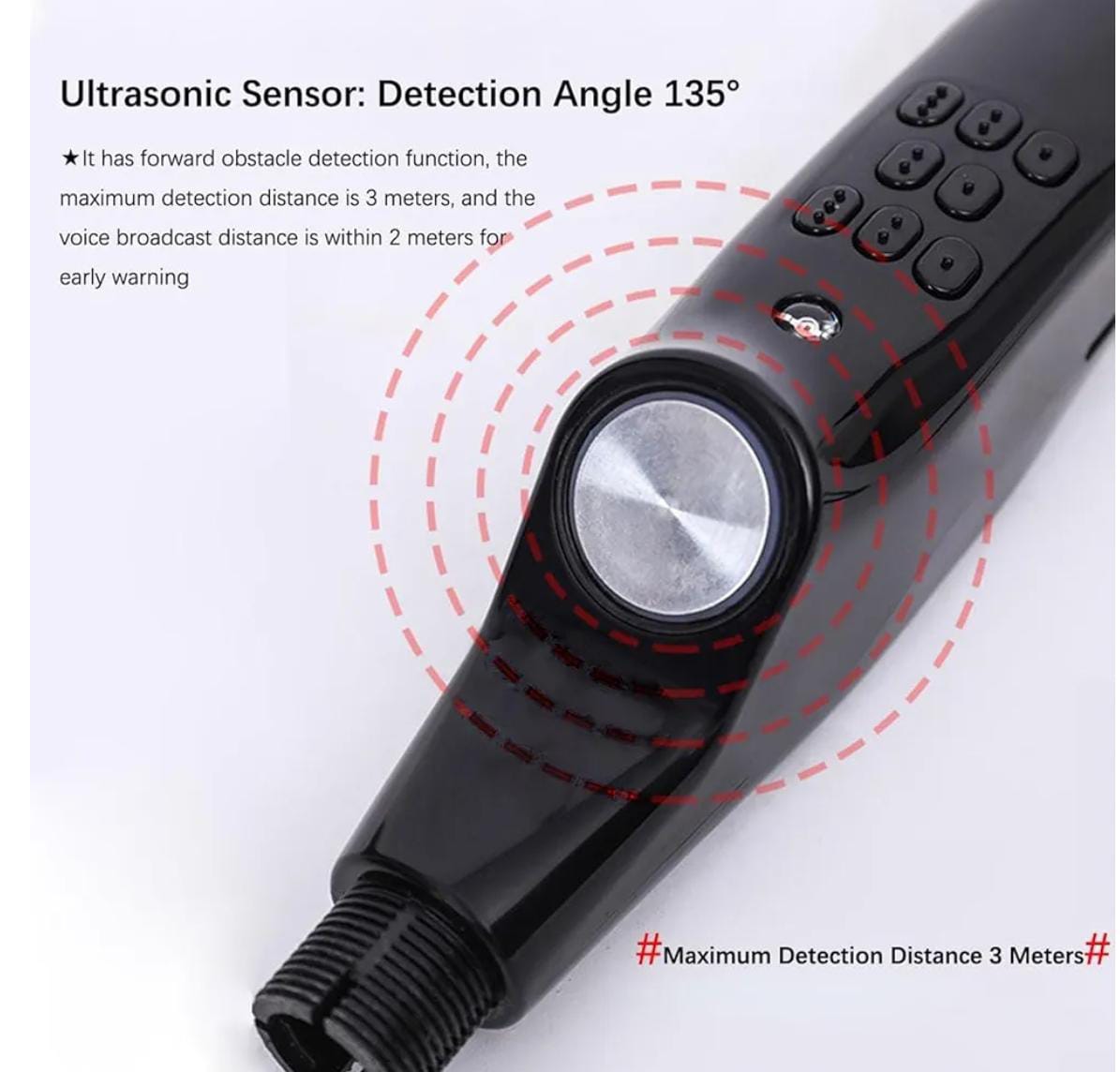

Ashirase es un sistema japonés de navegación háptica para personas con discapacidad visual que propone un enfoque poco habitual: trasladar las indicaciones de orientación al sentido del tacto, concretamente a los pies. No pretende sustituir al bastón blanco ni al perro guía, sino actuar como un complemento de orientación en exteriores que libera manos y oídos. Un aspecto especialmente relevante es que permite tanto seguir rutas pregrabadas como recibir indicaciones en tiempo real, adaptándose a trayectos planificados y a desplazamientos espontáneos.

Se trata de uno de esos dispositivos que despiertan interés precisamente por lo que no hace: no habla, no emite pitidos, no ocupa las manos ni compite con el oído. Su lenguaje es otro, basado en vibraciones en los pies, una guía silenciosa que, al menos sobre el papel, promete integrarse de forma casi invisible en la experiencia de caminar.

Para comprobar si esa promesa se sostiene en la práctica, en Infotecnovisión hemos querido ceder el protagonismo a quien realmente importa: una usuaria ciega que ha probado Ashirase en su vida diaria, en trayectos reales y durante un periodo suficiente como para formarse una opinión sólida y fundamentada. El texto que sigue es el testimonio íntegro de Wendi Arias Yamashiro, escrito desde la experiencia directa, sin filtros comerciales ni interpretaciones externas. Ella firma este artículo y asume plenamente su autoría.

Continuar leyendo “ASHIRASE, Tecnología en los pies: la apuesta japonesa para guiar a personas ciegas a través de vibraciones”